FAUT-IL AVOIR PEUR D’UNE IA ? INNOVATION DE RUPTURE OU ILLUSTRATION D’UNE PALINGÉNÈSE UNIVERSELLE DU MYTHE ESCHATOLOGIQUE ?

Au-delà des effets de mode, quoi de neuf dans l’intelligence artificielle ? Apporte-t-elle de nouveaux moyens de prendre des décisions et lève-t-elle le « brouillard de la guerre » ? Est-elle une innovation continue ou est-elle disruptive ?

L’IA, et l’engouement qu’elle suscite dans les ouvrages de science-fiction auprès du public, relèvent du mythe millénaire de créer ab initio des êtres intelligents plus ou moins à notre image, et dont l’avènement conduirait soit à notre épanouissement, soit à notre destruction ultime. Sans vouloir minimiser les opportunités et les défis du vaste domaine que représente l’IA, nous voudrions ici établir un regard moins sensationnaliste, en retraçant rapidement l’histoire de l’IA et inscrivant les résultats médiatiques récents dans leur dimension diachronique.

« Au regard du volume croissant d’articles, ouvrages, et vidéos nouveaux, mettant en exergue la révolution impulsée par l’IA, nous pourrions croire qu’il s’agit d’un domaine de recherche tout à fait récent. Il n’est est rien : le concept date des années 50 et une bonne partie des algorithmes que nous semblons (re)découvrir à l’œuvre aujourd’hui ont en réalité été produits dans les années 80. Ce qui constitue vraiment la révolution que nous connaissons depuis peu est le couplage désormais permis de ces algorithmes avec des données et une capacité de calcul qui n’étaient pas accessibles alors, ouvrant des perspectives dont on ne perçoit pas encore les limites. » (début de « La stratégie France I.A. », présentée le 21 mars 2017 en présence du Président de la République, avec déjà à l’époque en guest star Cédric Villani, sous l’égide du ministre de l'Economie et des Finances, du secrétaire d'Etat chargé de l'Enseignement supérieur et de la Recherche, et du secrétaire d'Etat chargé de l'Industrie, du Numérique et de l'Innovation.

« LES DÉSILLUSIONS SUIVENT LES ÂGES D’OR DE MANIÈRE CYCLIQUE »

Survol historique

En effet, les décennies se succèdent et ne se ressemblent pas : les désillusions suivent les âges d’or de manière cyclique. Les années 50 et 60 voient les premiers engouements avec l’âge d’or du raisonnement symbolique, médiatisé par les démonstrateurs de théorèmes de géométrie (c’est la naissance des premiers logiciels de calcul formel !) et Eliza, programme informatique simulant l’entretien avec un thérapeute, véritable ancêtre d’un chatbot médical.

Les années 70 sont une première désillusion, avec mise en évidence des limitations des modèles utilisés précédemment (pour le

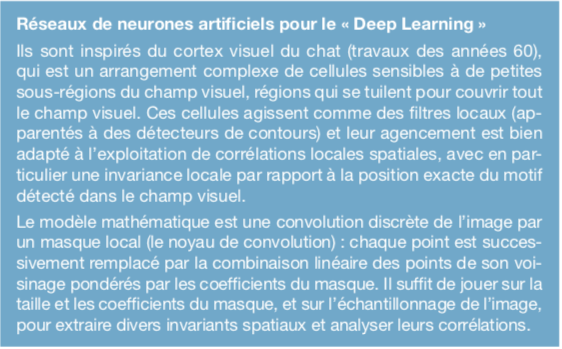

spécialiste : limite théorique des perceptrons qui sont les premiers modèles de réseaux de neurones artificiels, limite des hypothèses de monde clos pour les algorithmes symboliques et explosion combinatoire face à des données bruitées).

Les années 80 voient un renouveau de l’IA, avec le projet japonais « Ordinateurs de 5e génération », l’explosion des systèmes experts et des langages logiques (Lisp, Prolog...) et évidemment les méthodes de rétropropagation du gradient qui améliorent un algorithme déjà connu et remettent sur le devant de la scène les réseaux de neurones artificiels.

Suit une nouvelle désillusion dans les années 90 et 2000, avec plus ou moins les mêmes critiques que vingt ans auparavant, même si vers la fin des années 2000 la croissance importante de la puissance de calcul et le développement des architectures distribuées à faible coût laissent entrevoir des possibilités calculatoires jusque-là inenvisageables.

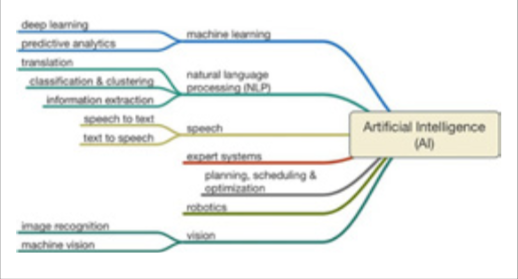

Les grandes branches applicatives de l’intelligence artificielle

La décennie 2010 est le nouvel âge d’or, du fait des succès pratiques, notamment en vision par ordinateur et traitement automatique du langage, d’une classe d’algorithmes, dits de « deep learning ». Là encore, c’est une adaptation d’algorithmes des années 70-80 rendue possible par la puissance de calcul et conduisant à des résultats inespérés du fait de la capacité de pouvoir traiter un nombre très élevé de données d’apprentissage. Pour le spécialiste, il ne s’agit ni plus ni moins que de réseaux de neurones artificiels multicouches convolutifs acycliques avec rétropropagation et descente de gradient, et apprentissage par renforcement (ceux qui ont dû subir certaines de mes interventions à l’ENSTA le siècle dernier ne se souviennent peut-être pas de planches que je présentais sur ces sujets...).

Faut-il craindre l’IA ?

Soulignons d’abord la polysémie du terme. Pour le Larousse, l’IA est l'ensemble de théories et de techniques mises en œuvre en vue de réaliser des machines capables de simuler l'intelligence. Cependant certains aiment à parler d’une IA (et pas de l’IA) qui serait une machine raisonnant comme ou mieux qu’un humain, bref ce que les Anglo-saxons dénomment GPAI, pour General Purpose Artificial Intelligence. En gros on imaginerait alors un algorithme qui serait à lui seul capable de tout faire, en particulier de se paramétrer lui-même en fonction des problèmes ou situations à affronter.

Fantasme séduisant, mais a priori éloigné comme le pensent de nombreux scientifiques (mais de nombreux autres pensent le contraire... donc ce n’est pas vraiment une preuve !), ainsi que Gartner Inc. dans son rapport de 2017: «this is not to say it will never be possible to build a machine that approximates the cognitive capabilities of humans, but we are likely decades away from having completed the necessary research and engineering ». Évidemment certains objecteront les

succès d’AlphaGo qui a battu au go un joueur humain en 2015 puis a acquis un niveau surhumain en 2017, ainsi qu’aux échecs ; et qui a gagné au poker en 2017 ; et qui a acquis des niveaux surhumains ou de première classe à un certain nombre de jeux Atari populaires dans les années 80.

Ceci dit, quand on y regarde de plus près, il y a quand même une certaine préparation (faite par un humain) de l’algorithme pour chaque nouvelle classe de jeux. Par ailleurs souvenons-nous qu’un autre algorithme (Watson d’IBM) a remporté le match humain-machine à Jeopardy (Questions pour un champion en France) en 2011, que d’autres en ont fait de même aux échecs en 1996, aux dames en 1994, à Othello dans les années 1980... Faut-il donc vraiment avoir peur parce que des ordinateurs jouent mieux qu’un humain à des jeux ? C’est tout au plus démoralisant pour les enfants... Et si l’on veut se rassurer, une machine peut aussi se tromper : il n’y a qu’à voir les accidents par exemple sur des Tesla pilotées automatiquement. Errare mechanicum est !

Une réponse plus théorique est que même les algorithmes les plus efficaces, comme l’apprentissage profond, souffrent de limitations propres aux réseaux de neurones, qui limitent la classe des problèmes susceptibles d’être résolus : il s’agit du surapprentissage (« overfitting » : le réseau correspond à une fonction d’approximation entre entrées et sorties du réseau qui colle trop aux données d’entrée et donc au bruit, et qui n’arrive plus à généraliser, ne reproduisant que bêtement les données fournies), de la disparition du gradient (« vanishing gradient » : en passant d’une couche à l’autre du réseau, le gradient propageant les erreurs tend vers zéro et l’algorithme de rétropropagation ne donne plus de résultats pertinents comme il devient de plus en plus sensibles aux erreurs de calcul), de la dimensionnalité (plus il y a de données multidimensionnelles, plus des corrélations vont être trouvées, mais elles ne sont pas exploitables ensuite : en fait une des capacités du raisonnement humain est d’abstraire les données pour ne voir que certains traits qui paraissent pertinents et semblent expliquer ces données).

La crainte majeure est en fait celle de l’inconnu : la plupart des gens ne comprend ni comment les algorithmes fonctionnent, ni comment ils évoluent en fonction des données traitées. D’où d’ailleurs un des axes du rapport de Cedric Villani rendu le 28 mars 2018 : favoriser un meilleur accès aux données. Mais ceci me semble une réponse illusoire à un

faux problème : pour qui un avion est-il complètement intelligible (à part nos camarades de l’aéronautique... éventuellement) ? ou une organisation complexe, comme le système éducatif ou celui de santé ? Êtes-vous capable de parfaitement comprendre les mécanismes d’apprentissage de l’ensemble des personnels œuvrant dans de telles organisations ? Et pourtant nous leur confions nos vies et les vies de ceux qui nous sont chers !

L’éthique et l’IA

Aujourd’hui l’IA apporte clairement un plus pour la défense et la sécurité, entre autres pour la représentation de la connaissance (modélisation de l’information, fouille de données), l’analyse de données (reconnaissance d’objets, indexation de flux vidéo), les interfaces homme-machines (chatbots, automatisation de fonctions de pilotage). Les applications à l’assistance au combattant et à l’aide à la décision sont donc d’actualité. De là à remplacer le combattant, le pas n’est pas encore franchi. À ce propos rappelons la doctrine, soulignée de nouveau par la Ministre des Armées au printemps 2018, qui affirme que la France ne s’engage pas dans les systèmes d’armes autonomes létaux (LAWS, « lethal autonomous weapons systems »), garde à tout moment un homme dans la boucle et est en pleine conformité avec les lois humanitaires internationales.

Ceci dit, on peut se poser la question de savoir si des IA (elles, pas ils !) n’auraient pas éventuellement un comportement plus humain que les humains, dans la mesure où elles ne connaissent ni colère, ni frustration, ni instinct de préservation, ni sens du sacrifice, ce qui in fine pourrait réduire les infractions éthiques conduisant à une réduction des exactions et des victimes parmi les non-combattants ; voire les IA pourraient servir d’observateurs objectifs et rapporter les infractions à des comportements éthiques. Cela repose cependant sur la capacité de modéliser et contrôler des comportements éthiques. C’est d’ailleurs un axe actuel de recherche, avec des approches à base de règles en logiques déontiques, des approches dites utilitaires...

Le problème d’une IA éthique, et/ ou d’une éthique de l’IA, est d’ailleurs l’un des quatre axes soulevés par le rapport Villani, et non le moindre !

Aucun commentaire

Vous devez être connecté pour laisser un commentaire. Connectez-vous.