OÙ EN EST LA ROBOTIQUE AUTONOME ?

Lorsqu’on voit les étonnantes vidéos de Boston Dynamics avec ses robots qui marchent, sautent, dansent, montent des escaliers ou lorsqu’on lit la presse généraliste sur les véhicules autonomes et les déclarations d’Elon Musk sur l’imminence de l’arrivée des véhicules totalement autonomes, la question se pose de savoir quel est le niveau d’autonomie accessible pour les véhicules et les robots. Faisons le point ensemble.

Boston Dynamics… bientôt 30 ans de développements

La société américaine suscite l’intérêt du public autant que celui des spécialistes avec ses robots dont les vidéos ont été vues par des millions d’internautes (https://www.youtube.com/watch?v=fn3KWM1kuAw). Après bientôt 30 ans de développement, les 4 robots de la gamme (l’humanoïde «Atlas», le quadrupède «Spot», les systèmes articulés «Pick» et «Handle» - https://www.bostondynamics.com) montrent leurs capacités sur des vidéos où ils marchent, sautent, dansent, montent des escaliers, ouvrent des portes...

Ces robots, auteurs de réelles prouesses en termes de mouvements, font l’objet d’un travail de rétro-ingénierie de la part de chercheurs afin de mieux cerner leur niveau de développement. Ils sont souvent apparus dans des vidéos avec des conditions bien maîtrisées en termes d’éclairage, d’encombrement de l’espace, d’aléas. Certains mouvements ont pu être programmés comme ceux des robots industriels qui assemblent des véhicules ou ceux des essaims de drones qui se produisent en spectacle dans différentes villes. Néanmoins, « Spot » a commencé à être testé par différentes entités (armée de terre en France, ville de Singapour) et entreprises (secteur pétrolier, chimique…) pour les confronter à des cas d’usages applicatifs. Boston Dynamics commercialise « Spot » depuis 2020 au tarif de 75 k$ et 400 exemplaires auraient été vendus la première année selon Bloomberg. Les premiers clients seraient des entités en quête de preuves de concept et des entreprises ayant des besoins de robots rondiers ou de robots d’inspection dans des environnements peu évolutifs.

Des voitures autonomes dans quelques années… (depuis plusieurs années)

Au vu des développements en cours dans le secteur automobile pour automatiser les véhicules, la SAE (Society of Automotive Engineers International) a développé le référentiel SAE J3016 qui fait autorité depuis le milieu de la précédente décennie :

- Niveau 0 : absence d’assistance à la conduite ;

- Niveau 1 : de premières assistances sont disponibles pour le conducteur (ex : régulateur de vitesse, ABS..) ;

- Niveau 2 : les assistances permettent l’exécution de certaines tâches élémentaires (ex : aide au maintien dans une file, aide au stationnement) ;

- Niveau 3 : le système automatisé peut exécuter certaines tâches en assurant le contrôle de son environnement (ex : Sur autoroute, la voiture peut doubler toute seule un véhicule quand le clignotant est actionné).

- Niveau 4 : le système automatisé peut effectuer la conduite de manière autonome dans certaines circonstances (types de route, conditions atmosphériques, densité de circulation… par exemple : conduite en mode autonome sur autoroute en l’absence de neige).

- Niveau 5 : le système automatisé peut conduire le véhicule en toutes situations.

Le niveau 1 est largement disponible depuis les années 2000, le niveau 2 l’est depuis quelques années et commence à être intégré dans de nombreux modèles. Le niveau 3 arrive depuis 2021 dans quelques véhicules haut de gamme (système Honda sur Legend EX homologué au Japon en mars 2021, système Mercedes homologué le 9 décembre 2021 en Europe – à noter que Tesla ne dispose pas d’homologation de niveau 3 fin 2021). Les niveaux 4 et 5 font l’objet de développements importants depuis la dernière décennie (par les constructeurs historiques et de nouveaux venus comme Waymo la filiale de Google, Tesla ou encore Valeo).

Pour de nombreux spécialistes, comme le cabinet Gartner (cf. Hype Cycle for Automotive Technologies, July 2020), il faudra encore plusieurs années avant de disposer de premiers véhicules au niveau 4 et le niveau 5 nécessitera plus d’une dizaine d’années. La question se pose d’ailleurs de savoir s’il n’y aura pas un niveau « 4 ½ » pour les autoroutes, les voies principales et les zones urbaines où l’infrastructure collaborera avec les véhicules via des systèmes de communication V2I (Vehicle to Infrastructure). Des projets publics européens comme Scoop et Safe Strip commencent l’expérimentation de tels systèmes pour transmettre aux véhicules des informations sur des événements à venir (zone de travaux,…) ou sur des événements détectés par les autres véhicules (accident, verglas…).

La longue route de la robotique autonome

Le principal défi du développement des systèmes robotiques est de détecter et comprendre l’environnement qui les entoure et de faire face aux événements imprévus. Le niveau d’autonomie nécessaire déprendra de la structuration de l’environnement, de son caractère coopératif, enfin de sa dynamique et de sa prévisibilité :

- L’environnement peut être plus ou moins structuré (cas des routes, des rues) et plus ou moins encombré. Entre les trois milieux (air / terre / mer), le milieu terrestre est le plus complexe en raison de la diversité des obstacles / des objets et c’est dans ce milieu que la robotique évoluera le plus lentement vers l’autonomie.

- L’environnement peut être plus ou moins coopératif (via un système de positionnement global comme le GPS ou demain GALILEO, via des infrastructures communicantes comme dans le cas des systèmes de communication V2I).

- L’environnement peut être plus ou moins dynamique, plus ou moins prévisible pour les systèmes qui y évoluent. Le nombre de mobiles, leur comportement, leur prévisibilité ont ainsi une influence. Une voiture autonome aura un comportement plus prévisible qu’un piéton. Plus il y a de mobiles variés (piétons, cyclistes, trottinettes…) et en nombre, plus ils sont susceptibles d’avoir un comportement hostile, plus le niveau d’autonomie nécessaire est difficile à atteindre.

La perception constitue un défi pour atteindre avec un système robotique équipé de capteurs, l’équivalent des sens des humains. Les capteurs ont récemment progressé notamment grâce à l’apprentissage à partir de données et leur complémentarité permet d’améliorer les capacités de détection et de reconnaissance. Mais la fusion de données n’est pas sans difficulté car il faut apparier les percepts (appartiennent-ils aux mêmes objets, ou à des objets distincts ?) et faire face aussi parfois à des artefacts. Le raisonnement est l’autre défi majeur. Il nécessite de modéliser le problème en termes d’espace, de temps et de description des événements. La modélisation du jeu de go est assez différente de celle d’un théâtre d’opération aéroterrestre avec des amis, des ennemis, mais également des populations.

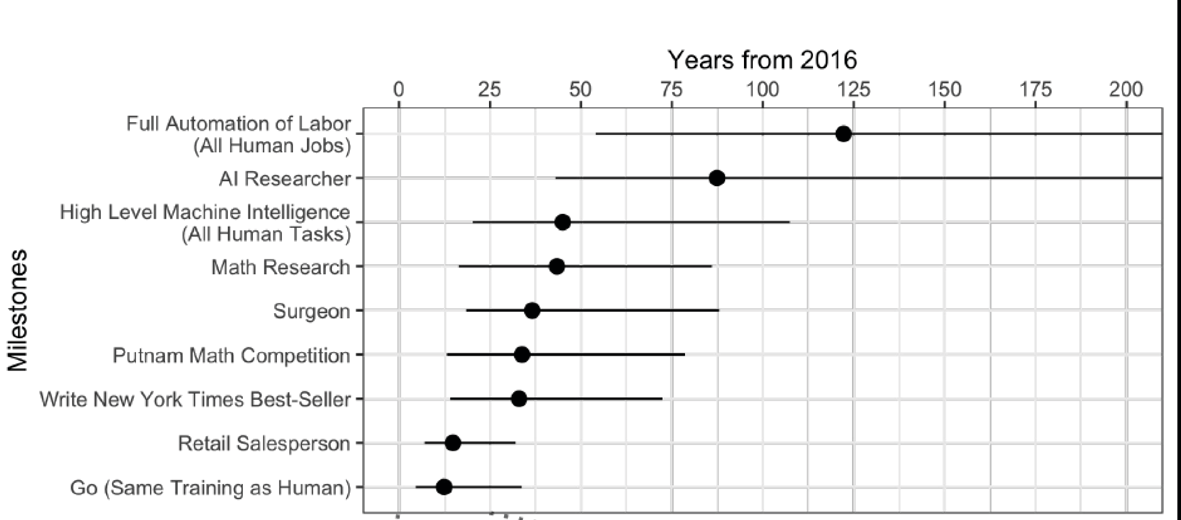

Figure : Estimation prospective du temps nécessaire pour que l’IA atteigne ou dépasse les performances humaines selon différents objectifs considérés, les ronds noirs représentant une probabilité d’atteinte de 50%. Source : When Will AI exceed human performance ? evidence from AI experts – Oxford University – Yale University

Même si l’intelligence artificielle a fait des progrès ces dernières années, c’est surtout la réalisation de tâches élémentaires qui a percé avec la fouille de données structurées et la recherche de corrélation entre celles-ci notamment dans le commerce électronique (aide à la fixation des prix, recommandations de produits proches…), le marketing (ciblage des offres, anticipation de tendances…), la maintenance industrielle… Les premières applications sur des données non structurées (traitement de la parole et traitement d’images) commencent à être industrialisées dans des enceintes domestiques ou des smartphones. Elles concernent aujourd’hui des applications bien circonscrites, comme la transcription de la parole, la recherche d’informations simples ou la reconnaissance d’objets dans des images (dans le visible). Même si les progrès accomplis récemment sont indéniables, il reste encore beaucoup à faire pour aller au-delà d’applications permettant d’effectuer de manière automatisée des tâches élémentaires ou très spécialisées (jeu de go, robot aspirateur).

Et en défense ?La robotique de défense bénéficie du dynamisme de la robotique civile et de l’intelligence artificielle, via des algorithmes génériques qui sont majoritairement disponibles en open-source.

Néanmoins, plus les sujets à traiter sont éloignés de cas d’usage civils (sujets et types de données) et de plus la conception des chaînes algorithmiques et leur paramétrage nécessitent un effort particulier pour le secteur de la défense avec la nécessité de débuter les travaux à des niveaux de TRL assez bas. La modélisation d’une situation opérationnelle de combat terrestre comparée avec celle du jeu de go a déjà été évoquée. Concernant les capteurs, on utilise des données d’imageur thermique, de radar de surveillance aérienne, de guerre électronique qui ne sont pas traités par le secteur civil. Autre exemple, concernant l’interface homme - machine : les grands acteurs du numérique s’intéressent surtout à la traduction automatique entre des langues courantes et l’anglais ou le chinois ; la défense a besoin d’assistance à la traduction entre le français et des langues parfois rares que l’on rencontre sur les théâtres d’opération. De manière générale, les systèmes robotiques militaires présentent des caractéristiques particulières : systèmes ne disposant pas forcément de liaisons haut débit pour des raisons de discrétion ou de brouillage, robotique en milieu non coopératif et non structuré (contrairement aux véhicules sans chauffeur), haut niveau de sécurisation exigé... Il est par ailleurs nécessaire de tenir compte du besoin d’intégration de ces systèmes avec les grandes plateformes dont ils dépendent (interopérabilité du système robotique avec le système d’information de celle-ci). Tout cela n’empêche pas le développement de robots et de drones qui restent majoritairement téléopérés voire avec un certain niveau de supervision comme le montrent d’autres articles de ce numéro. |

Concernant l’accessibilité pour un robot à des tâches complexes via l’intelligence artificielle, plus de 300 chercheurs et spécialistes en IA avaient été interviewés en 2016 et avaient fourni leur estimation sur le délai nécessaire en fonction des objectifs considérés (cf. figure jointe). Les avancées de ces cinq dernières années ont permis de progresser mais ne remettent pas en cause les ordres de grandeurs mentionnés à l’époque (pour le suivi de l’évolution des performances sur différentes tâches élémentaires consulter aiindex.stanford.edu). Cela laisse des perspectives pour des générations de chercheurs, y compris d’ingénieurs de l’armement !

|

Jérôme Lemaire, IGA, Chef du Service de la Qualité à la DGA Après une thèse et près d’une dizaine d’années en intelligence artificielle et robotique, Jérôme Lemaire s’est orienté vers les systèmes de systèmes, d’abord pour préparer SCORPION puis comme directeur du programme SCCOA. Après une immersion dans les achats d’armement, le Délégué lui a confié à partir de fin 2017 une mission sur l’intelligence artificielle, puis une mission sur la transformation numérique. Il a pris la direction du Service de la Qualité le 1er janvier 2022.

|

Auteur

Après une thèse en intelligence artificielle à l'ONERA et SupAero et plusieurs années comme expert et chef de projet en robotique sous-marine, j'ai rejoint le domaine des systèmes de systèmes d'abord terrestre où j'ai contribué au lancement du programme SCORPION, et à la conduite du programme SCCOA de commandement et de contrôle des opérations aériennes comme directeur de programme. Après des responsabilités importantes sur les marchés de défense en tant qu'adjoint au chef des marchés de la DGA, je me suis occupé de l'accélération des efforts du Ministère en intelligence artificielle avec la task force IA puis de la DGA sur sa transformation numérique jusqu'à fin 2021. Voir les 2 Voir les autres publications de l’auteur(trice)

Aucun commentaire

Vous devez être connecté pour laisser un commentaire. Connectez-vous.