Vers une intelligence artificielle de confiance, transparente, explicable et éthique

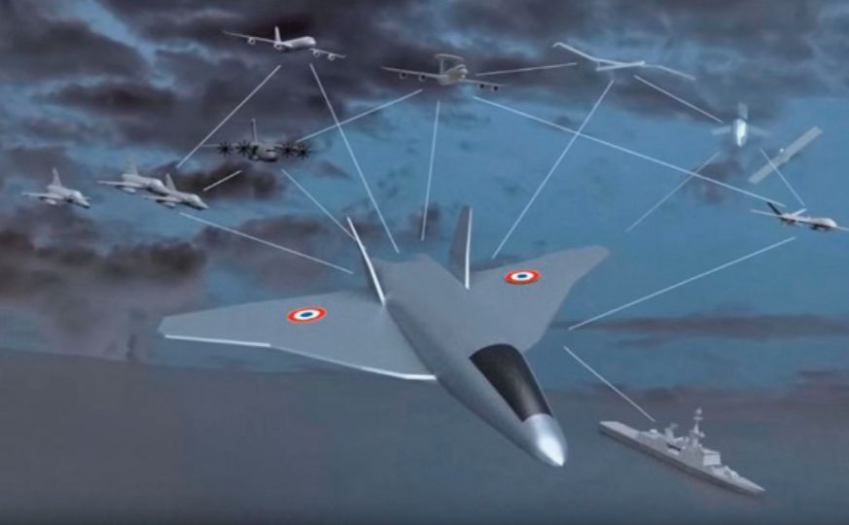

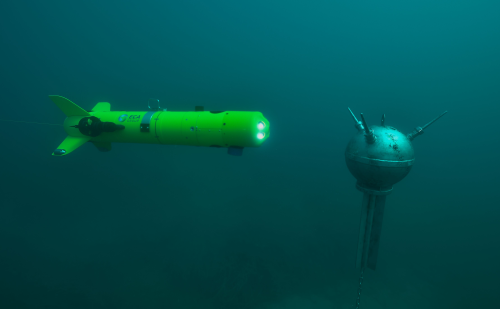

Dans le secteur de la défense, où des vies sont en jeu, la manière dont s’organise la prise de décision prend tout son sens. Qu’en est-il avec l’arrivée prochaine de l’intelligence artificielle (IA) dans ce contexte ? Quelles sont les conditions pour que, par exemple, des drones « intelligents » soient considérés comme de vrais équipiers ?

L’IA telle qu’on la présente aujourd’hui dans les médias est souvent limitée à une boîte noire qui a appris à nous aider par exemple dans nos recherches sur Internet. Le résultat est parfois impressionnant, mais s’il peut être suffisant pour le grand public, il n’en est pas de même pour des environnements aussi critiques que celui de la défense, qui n’autorisent aucun droit à l’erreur. C’est pourquoi il est nécessaire d’adapter l’IA pour répondre à de tels environnements.

Si l’on prend par exemple le cas d’un avion de combat, les relations entre le pilote et son équipier sont très particulières. La confiance, la transparence dans l’échange, la compréhension mutuelle, voire la connivence, sont des points clés qui feront la différence lors d’un combat aérien. Il doit en être de même avec l’IA.

Imaginons un échange entre un pilote et une IA dans un avion de combat escorté par un escadron de drones. Voici ce qu’il faut éviter :

- IA : Détection de deux cibles rapides à 50 nautiques en rapprochement.

- Pilote : Reçu. On se prépare pour engager la plus proche.

- IA : Cible 1 a une trajectoire anormale. Il faut la traiter en priorité.

- Pilote : Reçu.

Les drones équipiers s’éloignent de l’avion pour engager la cible 1

- Pilote : Equipiers, il faut resserrer la formation, pourquoi cet éloignement ? Je ne comprends pas votre manœuvre.

- IA: ...

- Pilote : Attention, la cible 2 engage à son tour et devient prioritaire.

- IA : La cible 1 est identifiée comme un leurre avec une probabilité de 85%. Reconfiguration des drones équipiers sur la cible 2.

- Pilote : Trop tard. On n’a plus la supériorité, on désengage et retour base.

Et voici ce qu’il faut parvenir à mettre en place :

- IA : Détection de deux cibles rapides à 50 nautiques en rapprochement. La cible 1 est la plus proche. Elle a un comportement anormal.

- Pilote : Reçu. On se prépare pour engager la cible 1.

- IA : Il faut engager la cible 2 et non la cible 1. La cible 1 est identifiée comme un leurre avec une probabilité de 92%. Reconfiguration des drones équipiers sur la cible 2. Confirmé ?

- Pilote : Confirmé.

Les drones équipiers engagent la cible 2

- Pilote : Cible 2 détruite, on désengage et retour base.

Ce dialogue n’a pas la prétention d’être réaliste, mais il vise à illustrer quatre propriétés indispensables à tout système critique intégrant de l’IA : la validité, l’explicabilité, la responsabilité et la sécurité.

La validité est la conformité stricte du système à ses spécifications. Le système ne doit faire ni plus, ni moins que ce pour quoi il a été conçu. Les critères de choix pour prendre une décision (quelle cible prioritaire, quelle optimisation de trajectoire...) doivent être identiques pour le pilote et pour son équipier, qu’il soit virtuel ou humain. C’est la base de la confiance.

L’explicabilité est la capacité de l’IA à justifier son action ou les recommandations qu’elle prodigue. C’est une fonction nécessaire au moment du débriefing, mais qui s’avère encore plus essentielle en cours de mission : l’équipier même virtuel doit pouvoir fournir au pilote en temps réel des explications sur son action, dans un langage compréhensible, naturel et intuitif. Quel que soit le mode d’échange, de l’affichage de données à l’utilisation d’une voix parlée, tout doit être clair, rapide, précis. Idéalement, l’IA devrait pouvoir apprendre à connaitre le pilote pour adapter ce qu’elle lui présente de manière efficace.

La responsabilité de l’IA est sa conformité à des standards et des principes, notamment éthiques. La protection des personnes peut parfois s’opposer à l’optimisation de l’effet militaire pour laquelle l’IA a été spécifiée. C’est la raison pour laquelle la responsabilité d’une décision critique ne peut être confiée uniquement à une IA. En particulier, l’opérateur doit maîtriser la prise de décision lorsqu’une vie humaine est en jeu. Dans le cas d’un avion de combat, l’IA engage la vie du pilote.

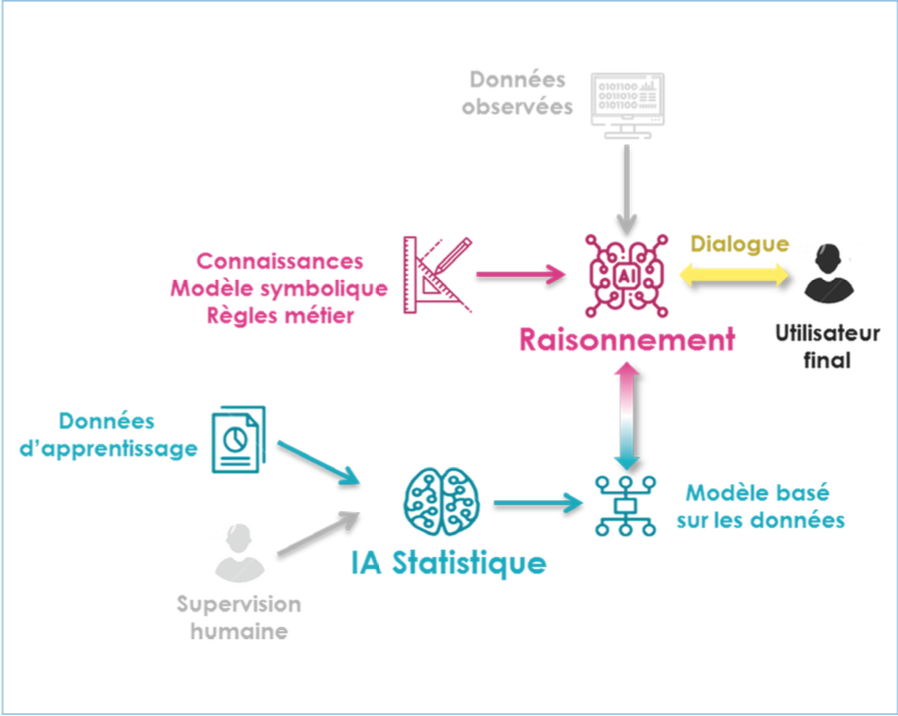

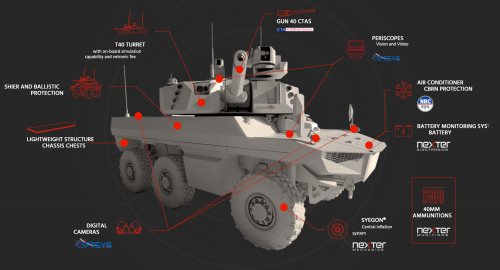

Un exemple de mise en œuvre d’IA hybride combinant IA statistique (par les données) et IA symbolique (par les modèles)

Enfin, la sécurité de l’IA, sa robustesse face aux attaques, est essentielle. Une intrusion cyber peut générer de fausses pistes dans un système de surveillance. Dans le monde physique, l’utilisation de leurres, de cibles atypiques ou de comportements non conformes peut déstabiliser une IA qui n’y aura pas été confrontée dans sa phase d’apprentissage. Le développement d’IA dédiées à l’affrontement d’autres IA ne serait-ce que pour les aider à progresser entraine aujourd’hui une véritable course dans l’art de berner les systèmes à base d’IA. Dans notre scénario fictif, le leurre adverse a cherché à déstabiliser l’IA par un comportement erratique. Outre la robustesse face à une attaque, la sécurité de l’IA nécessite également de traiter les conditions anormales d’utilisation, comme par exemple le cas de l’erreur humaine.

La satisfaction de ces propriétés n’a rien de simple. Elle met en lumière les limites des méthodes d’IA statistiques basées sur des réseaux de neurones apprenants à partir de grands volumes de données. Si ces méthodes sont inégalables pour la reconnaissance de formes (patterns) dans un environnement complexe (objetdans une image, traitement du signal, analyse comportementale...), elles se révèlent limitées pour conduire un raisonnement structuré comme le fait un être humain, puis d’en rendre compte en des termes explicites et intelligibles. Pour franchir ce plafond de verre, la trajectoire vertueuse pourrait résider dans l’hybridation de méthodes statistiques (IA par les données) et de méthodes symboliques (IA par les modèles) intégrant des règles et des représentations logiques basées sur l’expertise. Associée à un dialogue fluide entre l’Homme et la machine, la combinaison des deux approches renforce les quatre propriétés exigées par les systèmes critiques.

|

Hier, dans les études des performances fonctionnelles de nos systèmes, on intégrait forfaitairement la sûreté de fonctionnement, qui englobe principalement quatre composantes dites « FMDS » : la fiabilité, la maintenabilité, la disponibilité et la sécurité. L’avènement de l’IA introduit des nouvelles composantes de confiance, à caractère éthique, qui témoignent d’un niveau d’abstraction plus grand. |

Les Thales InnovDays 2019, l’occasion de partager autour des innovations sur lesquelles travaillent pus de 20 000 ingénieurs, lieu de réflexion et de présentation en exclusivité de 70 démonstrations sous l’égide du Prix Nobel Albert Fert.

|

Les Thales InnovDays organisés fin novembre 2019 ont mis en lumière les ruptures technologiques et d’usage qui vont impacter dans les années qui viennent tous les métiers du groupe : Transport, Spatial, Défense, Services. On peut citer l’IA bien sûr, mais aussi la 5G, les objets connectés, ou encore les technologies quantiques, qui peuvent toutes potentiellement révolutionner notre monde actuel. Préparer ces évolutions nécessite un investissement soutenu en matière de recherche mais aussi de multiples collaborations avec des organismes de recherche publique, des PME et des start-ups partout dans le monde. |

L’hybridation se révèle également vertueuse en termes de frugalité, qu’il s’agisse du volume de données nécessaires à l’apprentissage sachant que dans le domaine de la défense, les bases de données sont par nature imparfaites voire biaisées, incomplètes et peu accessibles que des besoins en ressources énergétiques.

Pour aborder ces enjeux et répondre aux contraintes de ses clients, Thales a développé sa propre approche connue sous le nom de « Thales TrUE AI » :

Tr pour Transparent ou Trustable (de confiance),

U pour Understandable (explicable)

E pour Ethique.

Lors des Thales InnovDays de novembre 2019, 41 des 67 démonstrations présentées intégraient de l’IA de confiance selon la définition de Thales TrUE AI. L’arrivée de l’IA dans le monde de la défense est aujourd’hui une réalité. Dans une dizaine d’années, il y a fort à parier que l’IA sera si nativement présente dans toutes les innovations que plus personne ne songera à calculer un tel ratio...

|

Pierre Schanne, IGA, directeur des études amont Défense de Thales

X83, PhD, Pierre Schanne a été optronicien, directeur technique du CAD, adjoint au chef de la MRIS et secrétaire général des architectes de systèmes de forces. De 2013 à 2017, il dirige la Mission d’Innovation Participative du ministère de la défense qu’il dynamise. En 2018, est nommé président de la Section Carrières au CGARM avant de rejoindre Thales.

|

|

Thomas Reydellet, directeur des études prospectives et stratégiques de Thales

Ingénieur UTC, HEC, IHEDN, capitaine de corvette de réserve, Thomas Reydellet passe par le conseil avant de rejoindre Thales en 2005 où il occupe différents postes, responsable de ventes C4ISR, coordinateur d’études avancées au battle space transformation center, et depuis 2008 son poste actuel.

|

Aucun commentaire

Vous devez être connecté pour laisser un commentaire. Connectez-vous.