LES ENJEUX EUROPÉENS DE CYBERSÉCURITÉ

La transformation numérique est inéluctable mais doit être maîtrisée dans un contexte croissant de cyber-menaces où la mobilité et le cloud « public », indispensables mais transparents aux données, s’imposent partout. L’Europe souveraine et démocratique est confrontée à trois défis : comment réagir face aux manœuvres de subversion des opinions publiques ? Quelle solution imaginer pour protéger ses infrastructures vitales dans un monde ultra-connecté ? Enfin, comment protéger ses citoyens et ses entreprises du risque de pillage des données personnelles et du patrimoine informationnel ? Nous sommes tous concernés.

REPÈRES

Les graves incidents « cyber » depuis 2016 (virus Wannacry et NotPetya, manipulation par Cambridge Analytica des élections US, espionnage étatique de responsables politiques européens, fuites massives de données personnelles) ont montré les limites de nos organisations en matière de sécurisation de leurs actifs numériques. Parallèlement, l’approche dite périmétrique visant à contrôler les flux devient obsolète car la frontière « réseau » s’estompe avec la généralisation de la mobilité (4G puis 5G), du « cloud » public, de la data-science (machine learning) autour des réseaux sociaux.

Le règlement européen sur la protection des données personnelles apporte une réelle avancée juridique et politique mais les responsables politiques européens doivent encore renforcer leur vision stratégique et souveraine en déplaçant les mécanismes de sécurité vers davantage de contrôle de la donnée sensible au niveau des utilisateurs et de leurs périphériques.

La transformation numérique s’impose

Pour une grande organisation publique ou privée, la stratégie de « transformation numérique » procède d’une vision nouvelle qui se décline en contraintes stratégiques de conception ou « by design » :

- le cloud public qui apporte la scalabilité, l’agilité et le devops ;

- la sécurité et la protection des données personnelles

- la collaboration des utilisateurs et l’ergonomie des systèmes ;

- la mobilité, au sens ubiquitaire, dans un contexte de connexion à l’internet intermittente.

Deux phénomènes illustrent cette tendance et les enjeux de compétitivité et sécurité associés

Le cloud public devient une norme d’usage, y compris dans les systèmes sensibles.

Le cloud public apporte la rationalisation par le partage et l’économie d’échelle (scalabilité), l’efficacité opérationnelle (« Devops ») et l’interopérabilité des données via l’internet (ubiquité).

Sa résilience l'autorise à fonctionner même en cas d’incident ou sur-sollicitation et à garantir un retour à son état fonctionnel initial.

Le stockage déporté des données et le caractère ubiquitaire du cloud permettent de ramener les terminaux à de simples appareils de consultation. Il rend possible l’accès aux données en tout temps et en tout point du globe, du moment que le réseau est opérationnel.

En contrepartie, il aggrave la prééminence des géants de l’Internet et rend aléatoire la maîtrise de l’utilisateur sur ses propres informations.

Le cloud public devient le dispositif idoine pour faire face au volume et aux nombreuses variations des flux de données. Sa standardisation accélère le déploiement de nouvelles capacités et annule toutes les contraintes matérielles. Le cloud public peut aussi autoriser, par exemple via de nouvelles architectures de programmation asynchrone, un fonctionnement sécurisé « par conception » au niveau du terminal, cela même lorsque le terminal est disconnecté (connexion coupée ou aléatoire).

Il est appelé à devenir une simple commodité à l’instar des réseaux d’eau et d’électricité.

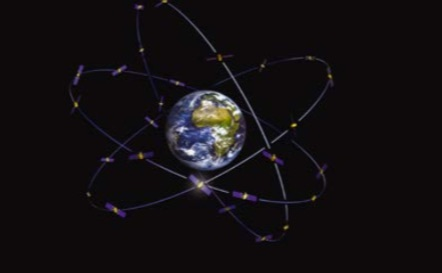

La 5G va compléter et remplacer la 4G à l’horizon 2020-2025.

La feuille de route de la 5G a été adoptée en décembre 2017 par les ministres des Télécommunications européens, dans le cadre de la présidence estonienne. L’Europe est en retard par rapport à la Corée du sud, aux États-Unis ou à la Chine du fait du caractère fastidieux des processus de délimitation et attribution des bandes de fréquences (perceptions inégales des « marges » nécessaires pour assurer la sécurité de services innovants), des difficultés dans la normalisation mais aussi, fait nouveau, des ressources financières insuffisantes au regard d’une industrie des réseaux affaiblie (au-delà de quelques succès comme Sigfox) (2).

Or, la 5G est appelée à décupler le Big Data par le biais de sa viabilité économique. L’Europe risque de faire face à des arbitrages difficiles entre vitesse de déploiement et maîtrise stratégique des coeurs de réseau, susceptibles de conduire à quelques écueils de sécurité (cf. le cas de la Lettonie).

Les menaces s’échelonnent sur quatre niveaux

Opérations d'information (« information ops » (3)) contre les valeurs démocratiques et européennes

L’Europe est ouverte et transparente puisque la liberté d’expression est protégée par l'article 10 de la Convention européenne des droits de l'homme. Cela procure

un avantage à ceux qui utilisent les technologies du Big Data et des réseaux sociaux pour déstabiliser nos institutions par l’arme de la subversion et de la désinformation. Les exemples de manipulation à grande échelle ou de guerre de l’information, ne manquent pas : le scandale « Canbridge Analytica » autour de l’élection américaine n’est qu’un exemple révélateur de ce phénomène dont la France n’est évidemment pas à l’abri.

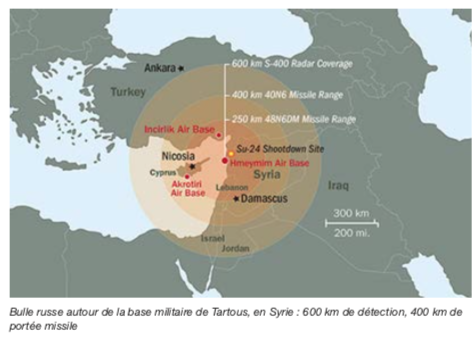

Cybermenaces contre les infrastructures et les activités stratégiques

Les outils informatiques d’origine étrangère, soit logiciels (OS, IaaS, PaaS, SaaS (4)) soit terminaux (smartphones, PC), sont très largement diffusés dans l'ensemble de l'Union Européenne, notamment au sein des administrations, des agences gouvernementales et des infrastructures d'importance vitale. Il sont largement contrôlés par des empires numériques multinationaux ou étrangers, en général peu enclins à la transparence et dont quelques-uns font parfois preuve, de manière notoire, de nocivité en matière de déstabilisation ou d’espionnage : ce sont autant de menaces supplémentaires pour les données et les activités stratégiques des institutions et acteurs économiques européens. Ces derniers font l’objet de contrôles à l’exportation ou de lois d’extraterritorialité qui menacent la sécurité de nos systèmes vitaux, de nos données confidentielles, et la sérénité de nos concitoyens.

Dans un monde où le cloud est amené à devenir une simple commodité manipulant des données chiffrées par conception, la maîtrise du terminal est la clé de l’accès sécurisé aux données. Ainsi, la souveraineté de l’Europe en matière de données passe par sa capacité à contrôler sur le plan matériel et logiciel 100 % des terminaux d’accès à l’internet : nos libertés sont à ce prix.

Collecte de données personnelles de citoyens et espionnage des données de sociétés

Le règlement général sur la protection des données personnelles (RGPD) et la directive de sécurité des réseaux (NIS) du 6 juillet 2016 représentent au plan juridique une avancée notable et indiscutable dans la résolution des problèmes de confidentialité des données et de certaines infrastructures nationales critiques. Elles ont clairement suscité l’attention des acteurs politiques et des industries de l’information hors des frontières de l’Europe.

Le RGPD est même devenu un vecteur d’évolution culturelle profonde au sein des organisations, qui fera de la donnée un véritable « bien collectif » par rapport auquel chacun se sentira investi et redevable à son niveau, ne serait-ce qu’au niveau de son ou ses terminaux ; cela constitue aussi, nous le verrons, un facteur de saine gestion des projets cloud et Big Data.

Parallèlement, les GAFAM sont confrontés à des fuites massives de données personnelles, le Patriot Act permet aux agences sécuritaires gouvernementales américaines d'obtenir des informations dans le cadre d'une enquête sur des actes de terrorisme, et le Cloud Act du 23 mars 2018, réplique politique au RGPD, permet, « dans le contexte des enquêtes judiciaires » un accès rapide aux données en s'adressant directement aux fournisseurs d'informatique en nuage plutôt qu'en passant par une demande de traités d'entraide judiciaire (MLAT (5)).

« Cyber : la guerre permanente »

Dévoilé le 5 décembre 2018 à Paris dans les locaux de la Société d’encouragement pour l’industrie nationale, le livre de Jean-Louis Gergorin et Léo Isaac-Dognin, « Cyber – La guerre permanente », présente le numérique comme une révolution stratégique dans l’histoire des moyens offensifs. Le « cyber » devient un deuxième moyen alternatif, après la guerre, de « continuer la politique par d’autres moyens », pour faire référence à Clausewitz.

L’utilisation offensive du cyberespace peut avoir lieu au niveau :

- des couches « physique et matérielle » ou encore « logique et applicative » : cyber-espionnage, cyber-sabotage (attaque par Stuxnet des centrifugeuses d’enrichissement de l’uranium de l’Iran), cyber-intimidation (intrusion sans sabotage dans les systèmes de contrôle de nombreuses installations américaines de production et distribution électrique) ;

- des couches « sémantique et cognitive » : les attaques informationnelles diffusent ou manipulent numériquement l’information (publication de courriels piratés concernant Hillary Clinton).

Le cyber est un nouveau théâtre de guerre. Il donne un avantage décisif à l’attaquant qui peut recourir à des moyens économiques, dissymétriques et furtifs (impossibilité de trouver la provenance d’une attaque, ce qui pose la question de la nature de la réponse militaire à une agression de ce type).

Cet ouvrage propose des réponses concrètes à ces défis, notamment la création d’une agence internationale de la cybersécurité et une régulation de l’anonymat sur les réseaux sociaux.

Comment relever ces défis ? Quelques approches

Le logiciel libre contribue à une stratégie gagnante

Les technologies du cloud permettent désormais de construire son système d’information de façon agile, scalable et dans des délais très courts car la mise en production est instantanée (Devops). La stratégie gagnante consiste à articuler son système sur les composants libres d’excellente qualité disponibles instantanément et en grand nombre sur internet.

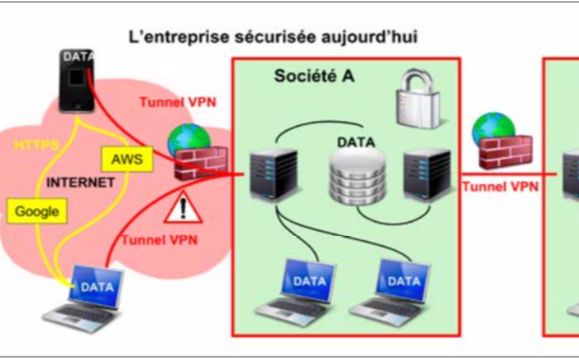

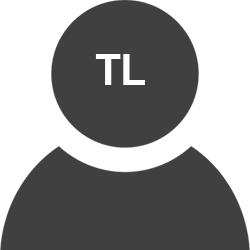

Evolution des paradigmes de sécurisation des données de l’entreprise

L’approche traditionnelle de la sécurité informatique d’une organisation part du postulat que l’utilisateur interne au réseau est fiable et que la menace réside à l’extérieur. Cette sécurité périmétrique se décline en deux barrières principales : chiffrement des flux réseau (VPN ou HTTPS) et dispositifs de filtrage réseau (pare-feux, antivirus, systèmes de détection d’intrusion, etc.). Cette approche est insuffisante parce que l’ouverture sur le monde est inéluctable.

Une première réponse communément adoptée consiste à structurer la sécurité autour de l’analyse des données : niveau de sensibilité, flux, acteurs et rôle de ces acteurs. On articule la démarche autour d’une analyse de sécurité de type EBIOS ou dans la série des ISO 27 000.

Une autre approche de type SOC (6) privilégie l’analyse des flux, l’intégration et la rapidité des réponses (rapprochement du temps réel) et le ciblage des événements atypiques ou signaux faibles (IA par exemple).

Ces deux approches sont fécondes, mais fastidieuses et centralisatrices : l’administrateur à fort niveau de privilège et le système de données toujours centralisé restent les vulnérabilités majeures.

Garantir un partage sécurisé des données selon un paradigme d’« architecture à confiance nulle » devient un enjeu majeur de la stratégie numérique de l’entreprise.

Une troisième voie, séduisante, consiste à placer le contrôle de la donnée au niveau de l’utilisateur et de ses terminaux qui portent alors l’essentiel des fonctions de sécurité (y compris dans leur dimension humaine). Ce paradigme consiste, à partir de terminaux de confiance, à utiliser le cloud public comme une simple commodité gérant des briques chiffrées redondantes, juste pour les avantages qu’il apporte, c’est à dire de la fiabilité, de la scalabilité, de l’ubiquité via l’internet. Il faut en revanche que l’utilisateur et son terminal s’arrogent le contrôle et la preuve absolus de tous les échanges de données. Des technologies existent comme l’intégration de la pile IP dans une carte à puce ou, plus adapté au monde du cloud, la programmation asynchrone couplée avec des enclaves de sécurité SGX (7).

Les fonctions de sécurité suivantes peuvent être contrôlées, le cas échéant, à partir de clés de chiffrement et de signature dont les composantes secrètes ne sortent pas du terminal :

- l'intégrité de ses données par la signature numérique afin de faire face aux risques de manipulation ;

- la confiance dans le transport grâce au chiffrement de bout en bout ;

- la confiance dans le partage via le chiffrement à « diffusion de connaissance nulle » ou « zéro knowledge » ;

- la disponibilité des données en s’appuyant notamment sur la résilience qu'offrent le cloud public et les réseaux ;

- la confiance dans les accès par l'authentification par des tiers de confiance (France Connect) et l'authentification forte à multiples facteurs ;

- la non-répudiation et l'authenticité par la signature numérique des données ;

- la vie privée et le respect natif du règlement général de protection des données ou RGPD ;

- la déterritorialisation par l’atomisation, le chiffrement et la redondance dans différents clouds ;

- la traçabilité, l'audit et l'historisation pour faire face notamment aux risques de violation et de compromission des données (ransomware) ;

- l’horodatage et la référence temporelle.

Une des difficultés principales de ce modèle d’architecture est de réussir à partager sans latence, l’information alors qu’elle est par construction verrouillée au niveau du terminal, ou encore de garantir la révocation immédiate des données ou des utilisateurs.

On mesure bien que le facteur-clé de succès de cette stratégie de sécurité est la maîtrise matérielle et logicielle du terminal d’accès à internet. On peut comprendre pourquoi IBM dépense 34 milliards de $ pour le rachat de Red Hat, société multinationale éditant des distributions GNU/Linux, ou pourquoi Canonical, l’éditeur de la distribution libre Ubuntu fait l'objet de spéculations de rachat pour 2019.

Dans ce nouveau paradigme de sécurité, la blockchain est également appelée à jouer un rôle central. Cette technologie innovante permet de garantir l’intégrité et l’authenticité des échanges, donc la confiance à partir d’une base distribuée et publique et indépendamment d’un tiers de confiance.

1 : Scille est une société spécialisée dans la transformation numérique de grands comptes et dans le partage de données sensibles sur le cloud.

2 : Sur les thématiques 5G et objets connectés, les projets d’innovation français portent surtout sur les processus et les couches applicatives, à l’exception notable des pôles Minatec et TES.

3 : Information ops : recours, combiné le cas échéant, aux moyens de guerre électronique, opérations de réseau informatique (CNO), opérations psychologiques (PSYOP), de subversion (MILDEC) et de sécurité des opérations (OPSEC), dans l’optique d’influencer, perturber, corrompre ou usurper une prise de décision humaine ou automatisée.

4 : OS : operating system (système d’exploitation) ; IaaS : Infrastructure as a Service ; PaaS : Platform as a Service ; SaaS : Software as a Service.

5 : Un traité d'assistance judiciaire mutuelle (TAJM ou MLAT en anglais) est un accord bilatéral pour faciliter la coopération policière et judiciaire, notamment en termes d’échanges d’informations et de données personnelles lors d’enquêtes en cours, à fin d’obtention de preuves ou d’éviter l’évasion fiscale.

7 : SGX : Intel® Software Guard Extensions (Intel® SGX) is an architecture extension designed to increase the security of application code and data.

Aucun commentaire

Vous devez être connecté pour laisser un commentaire. Connectez-vous.