ETHIQUE DES ROBOTS : SANS LIMITES

La frontière entre l’acceptable et l’inacceptable est souvent dépendante des modes et des époques : ainsi en va-t-il des robots. et parce qu’il est également illusoire de croire que les considérations éthiques fonctionnent par seuil, il se pourrait bien que nous finissions par atteindre demain, par petits pas, ce qui était inenvisageable hier. Voici un petit pot-pourri des enjeux.

Questions de seuil

Alors que j’étais en charge des technologies communes à la DGA, j’avais observé qu’il existait un frein déontologique aux développements technologiques et à leurs applications que j’appelais le « mur de l’éthique » qui prohibait, entre autres, l’automatisation extrême. Mais les murs sont parfois mobiles. Il suffit pour s’en convaincre d’imaginer une situation inacceptable pour se rendre compte que le chemin qui y mène depuis l’acceptable peut être parfaitement continu et sans ruptures. Est-il acceptable de créer des clones de combattants qui seront particulièrement exposés pour disposer de pièces de rechange ? Non. Et si ce sont des clones sans cerveau ? Aujourd’hui non. Est-il acceptable de cultiver un organe de rechange ? Probablement oui. De la peau de rechange ? Oui. Puisque certains coureurs du tour de France se dopent pour gagner, les soldats peuvent-ils se doper pour gagner la guerre ? Hier oui, aujourd’hui en France probablement non. Peut-on faire un tri génétique des soldats pour optimiser leurs chances de survie dans un environnement particulier ? Hier non, demain peut-être. Peut-on ne pas affecter dans le désert des blonds à la peau fragile ? Les médecins de mon service avaient tous des avis différents…

Ça commence plutôt bien : les 4D

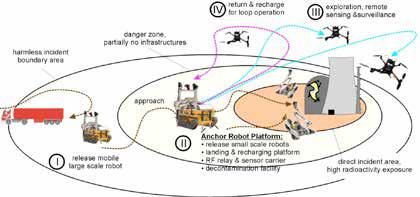

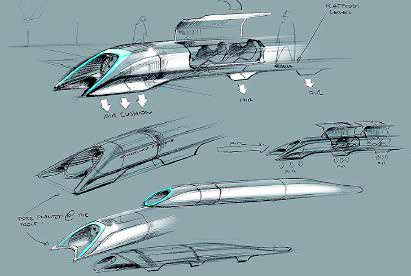

Créés essentiellement pour épargner aux humains des risques inutiles, les robots sont particulièrement adaptés aux missions dites « 4D » : Dull, Dirty (terme ambigu…), Distant et Dangerous. Moyennant quelques contraintes techniques, les robots sont utiles et appréciés. Dans cette configuration idéale, la limite est toute trouvée : tout ce qui nécessite une décision relève de l’humain. Même les ONG anti-robots s’en satisfont. Toute la question est de savoir quelles décisions il faut absolument remettre au jugement humain. Celle de frapper ? Les obus et munitions à identification autonome s’en affranchissent déjà. Celle consistant à autoriser le tir ? Nous utilisons depuis plus de 40 ans des systèmes d’autodéfense qui, sans la moindre intervention humaine, détectent, caractérisent et désignent leur cible, choisissent les armes à mettre en œuvre, puis tirent, détruisent et rendent compte du résultat. Depuis plus de 30 ans nous nous servons de systèmes dotés de logiciels fonctionnant non pas suivant une logique déterministe et maîtrisée, mais d’après une liste de règles d’intelligence artificielle. Depuis plus de 20 ans les automates boursicoteurs échangent, dans le respect de règles plus ou moins strictes, d’énormes sommes d’argent sur les places financières, et tiennent parfois de facto, dans des mains qu’ils n’ont pas, le sort de populations entières.

Premiers dérapages

Noyé sous un flot croissant d’informations, l’homme est assisté dans sa recherche de données par des robots toujours plus puissants, et la possibilité qu’un « super-cerveau » omniscient à la Google puisse être implanté dans le corps humain sous forme de puce relève chaque jour un peu moins de la chimère … Tel sera peutêtre l’homme du futur que nous décrivent avec enthousiasme les tenants du transhumanisme, être hybride mi-humain/mi-machine, artificiellement « augmenté » pour soutenir le rythme fou que lui impose une technologie devenue non maîtrisable. Sans aller jusqu’à une telle extrémité, plaçons nous dans l’hypothèse où l’homme futur sera accompagné de robots faisant corps avec lui. La privatisation croissante du génome humain pose dès à présent la question du statut juridique du gène : invention de laboratoire ou patrimoine de l’humanité ? Nous répondons aujourd’hui patrimoine commun, mais qu’en sera-t-il lorsque les gènes auront été transformés par l’intervention humaine ? Il se pourrait bien que l’homme finisse par ne plus pouvoir disposer de lui-même.

D’autres risques …

L’utilisation de robots à des fins militaires est une autre réalité qui s’impose à nous avec une ampleur nouvelle depuis déjà plusieurs années. Mais alors que le monde militaire opérationnel pourrait se saisir à bras le corps de cette question cruciale, force est de constater que les doctrines actuelles se contentent de rappeler l’importante mais monotone fameuse « place de l’homme dans la boucle », sans portée prospective aucune.

La réflexion doctrinale de l’état-major des armées sur la ROBOTISATION DE LA TROISIEME DIMENSION (JUILLET 2009)Orientations (extraits) : examiner les possibilités offertes par les drones armés ; maintenir l’homme dans la boucle pour le contrôle (décision, notamment en cas d’emploi de la force armée) et adopter une démarche prudente et mesurée pour développer l’autonomie d’action des robots. |

A cette situation s’ajoute la dévaluation morale dont pâtit l’opérateur de drone (qui ne bénéficie pas de l’aura des « vrais » pilotes), dévaluation dont les effets sur la qualité du recrutement pourraient s’avérer catastrophiques, alors même que l’importance croissante des robots exigerait au contraire de leurs utilisateurs des qualités humaines irréprochables. Enfin, l’interconnexion croissante de robots dont on ne pourra probablement jamais garantir la totale fiabilité des logiciels, constitue une menace réelle.

Qui est coupable ?

Autre question redoutable : quid de la responsabilité en cas de dégâts causés par un robot du fait d’une défaillance technique ? Qui est coupable, si l’utilisateur du robot l’a laissé sciemment évoluer dans un environnement propice aux comportements illégaux ? Les juristes diront que la culpabilité de l’exploitant, du propriétaire ou du réalisateur – termes ambigus – dépend des lois en cours, lois qui avaient été conçues sans imaginer de tels cas de figure … Une fois encore, le droit pourrait être en retard sur la technique. Le chemin continu menant à la symbiose (si l’on peut dire) des robots et des humains est tracé d’avance, et les verrous éthiques qui le jalonnent sont parfaitement connus : d’abord utilisée à des fins thérapeutiques, l’association homme-robot servira ensuite à augmenter les capacités humaines, d’abord sous parfait contrôle, puis selon des logiques de moins en moins compréhensibles dans le détail, puis pour des raisons hors de la portée de chacun, et enfin au titre d’une obligation dont l’enjeu serait la survie même, d’abord des individus, puis de l’espèce humaine dans son ensemble. Le lecteur d’aujourd’hui peut souhaiter que cette séquence s’interrompe un jour. Mais imaginait-on il y a cent ans que la greffe de cœur, autrefois impossible techniquement, mais surtout humainement, devienne un jour une opération banale ? Les robots susceptibles de franchir le mur de l’éthique sont déjà parmi nous, ils s’appellent « systèmes complexes ».

Autonomie et intelligence artificielle(…) les algorithmes actuels restent très en deçà des performances d’un cerveau humain.si une situation imprévue apparaît, la réflexion débouchant sur la créativité, apanage du cerveau humain, reste une aptitude essentielle.conformément à l’éthique occidentale, un système cybernétique pourrait difficilement se voir confier en propre des responsabilités, en particulier liées à l’usage de la force. Le problème de la responsabilité pénale serait alors particulièrement important, surtout en cas d’erreur. ainsi les décisions de haut niveau, en particulier celles susceptibles de porter préjudice aux individus, devront toujours être du ressort d’opérateurs humains (cette exigence s’inscrit dans la continuité des engagements pris lors de la signature de la convention d’ottawa interdisant les mines anti-personnel).si la guerre est une confrontation des volontés et la population l’enjeu essentiel pour obtenir une résolution durable des conflits, il est possible qu’une robotisation asymétrique des engagements nuise à la bonne perception de ces volontés par les populations visées. Les conflits récents (irak, afghanistan) ont montré les effets pernicieux d’un recours au « tout technologique » qui isole les forces combattantes du tissu social sur lequel elles doivent agir. L’emploi de robots ira certainement à l’opposé des efforts consentis pour gagner la « bataille du cœur et de l’esprit » offrant à la propagande adverse de nouvelles opportunités : dénonciation d’une « guerre des lâches », etc. L’implication de l’opérateur humain doit donc rester importante lors de la mise en œuvre des robots aériens, en particulier armés, même si le niveau d’assistance automatique peut être accru afin de faciliter la tâche des opérateurs. C’est la dimension morale qui doit décider de la place laissée à l’homme, en particulier dans l’expression et le contrôle de la violence d’etat.

|

Prendre le temps de la réflexion, mais vite !

La question de l’utilisation que nous souhaitons faire des robots rejoint très étroitement celle du choix de la civilisation dans laquelle nous voulons vivre et des moyens que nous souhaitons y consacrer. Ne nous laissons pas déborder par les progrès de la technologie, mais encadrons-la par une réflexion éthique dynamique et humaniste sur la signification morale de la fusion homme-machine, de l’intrusion de la machine dans le corps humain ou de l’utilisation à l’inverse de neurones humains dans les « cerveaux » cybernétiques. Acceptons de voir en face le caractère dérangeant de certaines recherches, et posons-nous la question de ce que nous voulons devenir. Et cessons de nous demander à chaque minute si nous sommes en train de franchir un seuil (il n’y en a pas), mais regardons plutôt dans quelle direction nous allons (car il y a, pour le coup, de mauvaises directions). Et ne tardons pas trop à le faire, car tout va très vite…

|

Denis Plane

Denis Plane a occupé pendant 6 ans un emploi de contrôleur général des armées en mission extraordinaire. Il est membre de la commission de déontologie des militaires et participe à des missions ponctuelles pour le ministère de la défense.

|

Auteur

Aucun commentaire

Vous devez être connecté pour laisser un commentaire. Connectez-vous.